이효섭 HEC Paris MBA/Sciences Po 정책학석사 복수학위 과정

[에듀인뉴스] 소프트웨어, 코딩을 넘어 인공지능까지. 빅데이터를 중심으로 한 응응 기술의 발전이 교육에 새로운 시대를 열고 있다. 에듀인뉴스는 ‘이효섭의 Tech 인사이트’를 통해 최신 기술 동향과 역사 간 접점을 찾아 새로운 기술의 개념과 응용 예시를 보다 쉽게 소개하고자 한다. 이번 연재는 어학 공부에 도움을 주기 위해 영문도 함께 제공한다.

천일야화에서

[에듀인뉴스] 옛날 옛적 인도의 한 술탄에게 세 명의 아들이 있었다고 한다. 맏아들의 이름은 후세인, 둘째는 알리, 막내는 아흐메드였다. 아버지를 닮은 세 왕자는 마음이 따뜻하고 용감하게 성장해갔다.

아들들이 성인이 되자 술탄은 세상에서 가장 귀중한 보물을 찾아오는 사람에게 왕좌를 물려주겠노라고 약속했다. 세 형제는 고국을 떠나기 전 도시 외곽에 있는 선술집에서 만나 1 년 후 왕궁으로 돌아가기 전에 만나기로 했다.

첫째 후세인은 서쪽에 있는 항구 도시 비스나가르로 떠났다. 거기서 그는 소유자를 즉시 원하는 곳으로 날아갈 수 있게 해주는 마법 양탄자를 손에 넣었다. 차남 알리는 북쪽 페르시아로 가서, 원하는 것이면 아무리 멀리 떨어져 있어도 볼 수 있게 해주는 마법의 망원경을 얻었다. 막내 아흐메드는 동쪽 사마르칸트에 도착하여 성스러운 과수원에서 어느 질병이든 치료할 수 있는 사과를 갖게 되었다.

세 왕자는 정확히 1년 뒤 약속한대로 도시 주점으로 돌아왔다. 거기서 그들은 알리의 마술 망원경을 사용해 이웃 나라의 아름답고 슬기로운 공주 누론니하르가 위중한 병에 걸렸다는 것을 알게 되었다. 세 형제는 누론니하르를 구하기 위해 후세인의 카펫에 올라 즉시 날아갔다. 막내 아흐메드는 자신이 왕국을 물려받을 기회를 잃게 될 것이라는 것을 알면서도 사과를 공주에게 먹여 그녀의 생명을 구했다.

누론니하르 공주는 몸이 회복되자 아흐메드를 남편으로 선택했다. 그녀는 “왕자님들 모두 제 생명을 구하기 위해 보물을 사용해 주셔서 감사합니다. 그러나 아흐메드 왕자님은 저를 위해 자신의 보물과 왕위를 모두 희생하셨기 때문에 그 분을 제 남편으로 선택하겠습니다”라고 말했다.

아들들이 모두 궁궐로 돌아오자 술탄은 생명을 살리기 위해 모든 것을 희생한 아흐메드에게 왕위를 물려주었다. 이후 아흐메드와 누론니하르 부부는 결혼해 행복하게 살았다고 한다.

이 이야기에서 우리는 세 왕자 모두의 보물이 공주의 목숨을 구하기 위해 필요했다는 것을 알 수 있다. 알리의 망원경이 없었다면, 그 누구도 공주의 병에 대해 알지 못했을 것이다. 후세인의 양탄자가 없었다면 제 시간에 도착하지 못했을 것이고, 아흐메드의 사과 없이는 그녀의 생명을 구할 수 없었을 것이다.

기술이 이룩한 멋진 세상

현대인들은 마법처럼 놀라운 기술로 가득 찬 세상에서 살고 있다. 2021년에 발사될 예정인 제임스 웹 우주 망원경(James Webb Space Telescope)은 인류가 지구에서 150만 킬로미터 떨어진 곳에서 깊은 우주를 관측할 수 있게 한다.

일반적인 제트 여객기는 시속 1,046km로 비행할 수 있다. 인간의 기대 수명은 18 세기 이래 두 배 이상 증가했으며 의학 및 제약 과학의 경이로운 발전으로 인해 건강까지 크게 향상되었다.

우주 관측, 이동 속도 및 의료 분야만이 최첨단 기술의 혜택을 받는 것은 아니다. 현대사회의 다양한 문제는 너무나도 복잡하기 때문에 첨단 기술뿐만 아니라 집단적인 창의력을 요한다.

오늘날 우리는 효율성을 위해 점점 더 많은 뇌의 기능을 자동화된 사고 과정인 알고리즘에 의존하고 있다.

예를 들어, 지휘관들은 군사 작전의 위험을 평가하기 위해 복잡한 알고리즘과 시뮬레이션에 의존한다. 미 연방법원 판사들은 데이터 분석 및 인공 지능에 의존해 범죄자에게 가석방을 허용해야 하는지 또는 감옥에 보내야 하는지 여부를 심의한다.

흥미롭게도 많은 사람들이 이러한 전환을 지지하고 있으며, 개인의 주관이 개입된 결정보다 편견과 사람의 실수를 최소화한 알고리즘이 보다 더 객관적이고 바람직하다고 신뢰한다.

데이터 중심 의사 결정이 사람의 감정이 섞인 육감보다 더 정확하고 탄탄한 과학을 기반으로 할 것이라고 생각하는 것이다.

인종 차별을 일삼는 나쁜 프로그램

이미지를 찾기 위해 검색 엔진에 "파티"라는 단어를 입력하면 얼굴에 활짝 미소를 짓는 사람들의 사진이 표시된다. 한편 “조직폭력배”라는 단어를 입력하면 무기를 든 사람들의 험상궂은 표정들을 볼 수 있다.

이전에 연재한 3회 “인공 지능과 마법사의 제자”에서 살펴본 대로 검색 엔진 알고리즘은 수백만 개 이미지를 입력한 프로그래머가 이미지에 부여한 의미를 통해 이미지와 관련 단어를 식별하도록 짜여 있다.

다시 검색창으로 돌아와 “파티”와 “조직폭력배” 검색결과를 유심히 살펴보자. 전자에는 백인이 많이 나오는 반면, 후자에는 유색인종이 더 많이 출력된다는 사실이 놀라울 수도 있을 것이다.

어쩌면 우리는 인종차별을 일삼는 프로그램을 쓰고 있는지도 모르겠다. 이런 검색결과는 흥미롭지만, 사법 사건 및 군사 작전과 비교하면 상대적으로 그리 심각하지는 않게 느껴질 것이다.

여기서 문제는 단순히 누군가를 감옥에 보내거나, 군인의 생명을 위험에 빠뜨리거나, 적정한 기준금리를 계산하는 것과 같이 사회에서 가장 중요한 결정들이 이러한 알고리즘에 점점 더 의존한다는 점이 아니다.

어찌 보면, 알고리즘은 올바른 결정을 시의 적절하게 내릴 수 있도록 도와주는 도구에 불과하기 때문이다.

진정한 문제는 그러한 알고리즘을 설계하는 소수 프로그래머들과 이러한 제품을 승인하는 더 적은 숫자의 임원들이 매우 유사한 배경을 가진 사람들이라는 점이다.

프로그래머와 임원들 개개인들이 인종차별 주의자가 아닐지라도, 사회에서 가장 중요한 결정을 내리는 데 기여하는 알고리즘을 설계하기 위해 비슷한 사고방식과 경험을 가진 사람들을 모아 놓는다면, 개개인들에게 잠재된 편견들이 증폭된 알고리즘이 탄생할 수 있다.

이렇게 만들어진 알고리즘은 피부색이나 성별을 기준으로 수많은 개인의 운명을 결정짓는 것이다.

아직 모든 것이 결정된 것은 아니겠지?

기술이 왜 그리고 어떻게 우리의 편견을 증폭하는 것일까? 구글이 창립된 지는 22년이 되었고 유튜브는 15년이 지났다. 불과 22년 만에 이 두 회사, 보다 정확하게 말하자면 이들의 소프트웨어 엔지니어 및 제품 관리자가 인류의 두뇌 작동 방식을 완전히 바꿔 놓았다.

이제 우리는 전화 번호, 중요한 날짜 및 일정과 등을 기억하기 위해 이러한 회사에 의존하고 있다. 또한 필요할 때 언제 어디서나 유용한 정보를 '불러오는(Loading)' 데 크게 의존한다.

이러한 획기적 변화가 매우 짧은 기간 동안 일어날 때, 많은 사람들의 삶에 영향을 미치는 규칙들이 우리 스스로 지닌 잠재적 편견을 인식하고 수정할 수 있는 충분한 시간을 주지 않으면서 고착된다. 이 이면에는 데이터 과학에서 과적합/부적합 문제가 차별주의적인 알고리즘의 배후의 범인으로 의심된다.

쉽게 말해, 인공지능을 훈련하는 데 사용되는 작은 표본 집단 자체에 편견이 녹아들어 있는 경우, 부적합(underfitting)이 발생해 편견이 내재된 알고리즘이 생성된다.

예를 들어, 이미지 검색 알고리즘에 "파티"라는 단어를 가르치기 위해 파티에 백인이 등장하는 1만장과 흑인이 등장하는 사진 100장을 사용하고, "조직폭력배"라는 단어를 가르치기 위해서는 1만장의 흑인 사진과 100명의 백인 사진을 사용했다면, 이 알고리즘은 흑인이 등장하는 사진은 “조직폭력배” 로 분류하고 백인이 등장하는 사진은 “파티 참가자”로 분류할 가능성이 높다.

마찬가지로 알고리즘이 매우 특정한 데이터 상관관계에만 집착해 좁은 정의를 구축할 때는 과적합(overfitting)이 발생한다. 실제로 이미지 검색 엔진이 인간과 고릴라를 구별하기 위해 피부색의 특성에 초점을 맞출 경우, 흑인을 사람으로 인식하지 못하고 고릴라로 오인한 결과가 검색되어 물의를 빚기도 했다.

인공 신경망에 입력된 데이터의 가중치와 편향치(bias)가 알고리즘 훈련의 결과를 왜곡시키는 기울기 소실(vanishing gradient) 문제는 알고리즘 성능 및 정확도 저하로 이어진다.

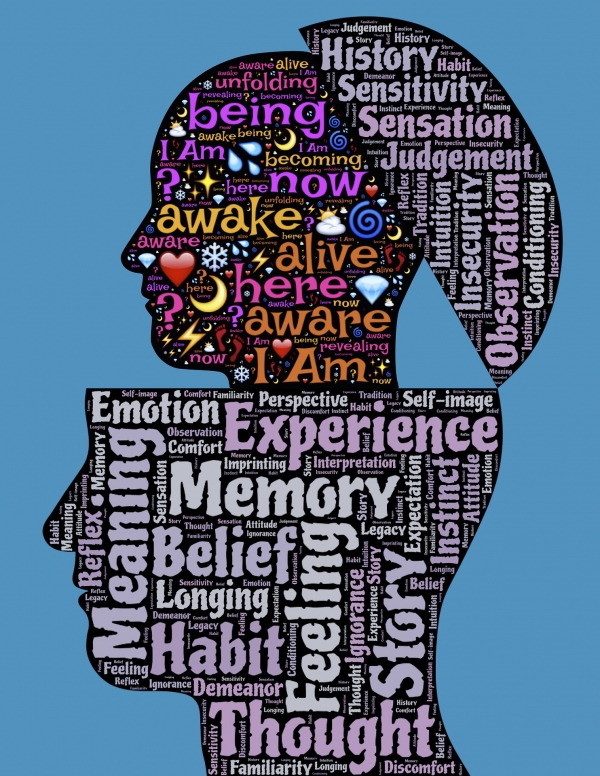

인간의 뇌와 마찬가지로 알고리즘과 신경망은 자신의 경험(데이터)의 한계에 취약하다. 이것이 바로 인류의 현재와 미래를 형성하는 최첨단 기술이 태어나는 실험실과 회의실에서 다양성이 필수적인 이유다.

스스로의 편견에 직면하기

기술은 우리의 인식과 편견을 증폭시킬 뿐만 아니라 이를 깨닫게 해준다. 예를 들어, 참가자들에게 동일 범죄를 저지른 두 사람에게 형사처벌을 선고하도록 한 실험에서, 험악하게 생긴 범죄자들은 잘 생기거나 미모의 범죄자들에 비해 무려 두 배에 가까운 형사처벌을 선고받았다. 이처럼 우리 스스로의 편견을 객관화하는 수치(數値) 데이터를 직접 보지 않고서는 이를 정확하게 깨닫기는 어려울 것이다.

다양성은 단순히 기업이나 국가에서 산술적으로 더 많은 여성과 더 다양한 인종을 고용해야 한다는 뜻이 아니다. 인류가 획득하게 되는 최첨단 기술이 보다 더 큰 불평등을 초래하지 않고 우리 스스로의 편견과 인식의 결함을 깨닫는 데 도움이 될 수 있도록 가능한 생각의 범위를 확장하는 것을 의미한다. 즉, 일차원적인 집단지성이 아닌 다중 지능을 극대화하는 것이다.

다양성은 단순히 인종/성별이라는 이차원적 방정식에 불과한 것이 아니다. 신경 다양성(Neurodiversity), 성격 다양성뿐만 아니라 개인적인 경험 및 각자의 이야기가 지닌 다양성도 고려해야 한다.

이미 구글, 아마존 등 기술 중심 대기업들은 독창적인 관점과 강력한 통찰력으로 알고리즘과 소통하는데 천부적인 재능을 지닌 신경다양성을 갖춘 인재들을 전략적으로 고용하고 있다.

2000년대 인텔의 광고 문구는 “여러분 모두를 초대합니다(Everyone’s invited)!”였다. 기술 분야에서 다양성은 더 나은 세상을 구축하기 위해 필수불가결한 요건이다. 진정한 다양성에 대한 존중과 포용은 다양성 그 자체의 다양한 차원을 고려하고 ‘다름’에서 비롯되는 진정한 인류의 가치를 받아들이고 적극적으로 활용하는 것을 의미한다.

공주의 생명을 구하기 위해 세 왕자의 양탄자, 망원경, 사과가 모두 필요했던 것처럼 인간의 존엄성을 지켜내는 기술 발전을 위해서는 진정한 의미의 다양성을 진지하게 수용하는 것이 필수적이다.

The Three Princes and the Meaning of Diversity

A Story from Arabian Nights

Long ago in India, a Sultan had three sons: Hussein the eldest, Ali the second, and Ahmed the youngest. The three princes grew up to be gentle and brave, taking after their father. As his sons came of age, the Sultan send them away on a quest to seek the most valuable treasure in the world and promised them the one who brings the most unique item will inherit the throne. The three brothers met in a tavern in the outskirts of the city and agreed to meet each other a year later before returning to the royal palace.

Hussein the eldest traveled west to the coastal town of Visnagar. There, he found a magic carpet that could instantly take the owner to the place he desired. Ali the middle son traveled north to Persia, where he found an enchanted telescope that could show him anything he desired. Ahmed set out east to Samarkand and found a rare apple that could cure any disease from a holy orchid.

The three princes returned to the city tavern as promised. There they found that Nouronnihar, a beautiful and wise princess of the neighboring kingdom had fallen ill, using Ali’s magic telescope. The three brothers got on Hussein’s carpet and instantly flew to save Nouronnihar. Ahmed used the apple to save the princess, knowing that this would mean he would be forfeiting his chance to inherit the kingdom.

When Nouronnihar recovered, she chose Ahmed’s to be her husband. She said, “I thank you all because your treasures were necessary to save my life. But Prince Ahmed had given up his own treasure. For his sacrifice, I choose him to be my rightful husband.” When his sons returned home, the Sultan chose Ahmed to be his successor upon hearing this story of self-sacrifice. Ahmed married Princess Nouronnihar and they lived happily ever after.

From this story, we find that everyone was needed to save the princess. Without Ali’s telescope the princes would have never known about Nouronnihar’s illness. Without Hussein’s carpet, they wouldn’t have arrived in time. And without Ahmed’s apple, the princess could not have been saved.

Technology to save the day!

We lived in a world filled with marvels of technology. The James Webb Space Telescope planned to be launched in 2021 can enable humanity to observe the deep cosmos from 1.5 million kilometers away from Earth. A typical commercial airliner can travel at 650 miles per hour (1046 km/h). Human life expectancy has more than doubled since the 18th century and the quality of physical life has increased dramatically through the wonders of medical and pharmaceutical science.

Space observation, mobility, and medical science are not the only areas that benefit from cutting edge technology. The complexity of modern problems requires not only advanced technology but also collaborative creativity. For efficiency, we rely more and more of our thinking to algorithms, an automated process of thought.

For example, generals rely on intricate algorithms and simulations to assess the risks of a military operation. Judges rely on data analytics and artificial intelligence to deliberate whether a criminal should be allowed parole or sent to jail. Interestingly, many support this transition and feel safer in the hands of machines than individual decisions, believing that it will eliminate biases and human error. After all, a data driven decision is supposed to be more accurate and based on hard science than just a hunch, right?

Bad racist machines

If you type in the word “party” in a search engine to look for images, you will find pictures of people drinking with big smiles on their faces. If you type in the word “gang,” you will find pictures of people with guns and a serious look on their faces. You might recall from a previous article, Artificial Intelligence and Der Zauberlehrling, search engine algorithms are programmed to identify images and associated words by learning from millions of images and the definitions the programmers attribute to the images.

Look closely at the pictures from both the words “party” and “gang.” You may be surprised to find there are far more white people in the former and more colored people in the latter. It looks like we have a very bad, racist machine. The results of a search query may be entertaining but not so serious relative to the outcome of criminal justice cases and military operations. The problem is not that the most important decisions of society such as sending someone to jail, putting soldiers’ lives at risk, or calculating the correct base interest rate increasingly rely on these algorithms. After all, algorithms are programmed to help make good decisions on time.

The problem is that there are only a small number of programmers from very similar backgrounds that design such algorithms, and even fewer executives that approves these products. Although these individual programmers and executive are not racists themselves, when we put people with similar backgrounds in a room to design algorithms that contribute to making society’s most important decisions, it’s very likely that the subtle biases of these individuals result in a amplified biases that can seal the fate of countless individuals based on the color of their skin or their gender.

It’s not written in stone… or is it?

Why and how does technology amplify or own biases? It has been only 22 years since Google was founded, and 15 since YouTube. In less than 22 years, these two companies, or more precisely the software engineers and product managers of these companies, have completely altered the way our brains work. We rely on these companies to remember things for us, such as phone numbers, important dates and our schedules. We also heavily rely on them to ‘load’ useful information for us whenever and wherever we need it.

When these groundbreaking changes take place over such a short period of time, rules that impact many people’s lives become fixed without giving them enough time to realize and correct potential biases. In data science, the over/underfitting problem is often suspected as the culprit behind racist machines.

Simply put, underfitting happens when a small data set used to train artificial intelligence has an inherent bias, it will result in a biased algorithm. For example, when we show 10,000 pictures of white people partying and only 100 pictures of black people partying to teach the word “party” to an image search algorithm, and 10,000 pictures of black people and 100 of white people to teach the word “gang,” the algorithm will very likely classify the gathering of black people as gangs and the gathering of white people as party goers. Similarly, overfitting happens when the algorithm is fixated only on very specific piece of data correlation and builds a narrow definition. A controversial image search result that failed to recognize a black individual as a person and mistook him for a gorilla might have been caused by focusing on skin color to distinguish humans from gorillas.

The vanishing gradient problem, where the weights and biases of the data input in artificial neural networks distort the result of the algorithm training, leads to poor performance and low accuracy of algorithms.

Just like the human brain, algorithms and neural networks are vulnerable to the limits of its own experience (data). This is a clear reason that diversity is essential in labs and boardrooms where the latest technologies that shape our present and future are born.

Everyone’s invited! Facing our own biases

Technology does not only amplify our own perceptions and biases. It also reveals them. For example, in an experiment that asked participants to deliver criminal sentence to the same crime to two individuals of the same ethnicity but with different facial appearances, people with the better-looking face received on average half the sentence of the other person. Without facing at the numerical data that quantify our own mistakes, how can we realize them?

Diversity does not mean to force companies and governments to mechanically have more women and more colored people. It means adding a spectrum of thought that the technologies we build do not create more inequality, and instead help us realize the fault in our own perceptions. It is to engage in a multiple intelligence approach. Diversity has more than two dimensions of race and gender. Neurodiversity and personality diversity as well as diversity in personal experience and narratives need to be considered. Tech giants are now seeing the indispensable value of neuroatypical individuals who can outperform neurotypical people in communicating with machines with their incredibly original perspective and insight.

Intel’s catchphrase in the 2000s was Everyone’s invited! Diversity in technology is now undeniably a vital requirement to build a better world. True inclusion means to consider the diverse dimensions of diversity itself and appreciate the value of difference inherent in our humanity. Just like all three Prince’s treasures, the carpet, the telescope and the apple were required to save Princess Nouronnihar’s life, the true meaning of diversity needs to be genuinely appreciated to safeguard human dignity in our technological progress.

이효섭 HEC Paris MBA/Sciences Po 정책학석사(Digital, New Technology and Public Policy) 복수학위 과정=고려대 법학과/경영학과를 졸업한 이효섭 씨는 전 국방부 국제정책관실 통역장교, 전 ㈜한국항공우주산업 KF-X 및 APT 사업 계약협상 담당과장을 지냈으며 Palantir Technologies 런던사무소 근무 예정이다.

"억지로 공부해서 대학도 가고 대학원도 왔지만, 공부하는 재미를 이제서야 깨우친 아저씨입니다. 한번에 읽히는 글, 진실이 담긴 글, 겸손한 글을 쓰기 위해 노력하겠습니다."